한때 우리나라의 하늘은 닫혀있었습니다. 그 때에는 해외여행이 자유롭지 않았습니다. 교수나 고위 공직자처럼 일부 특정한 계층만 해외에 갈 수 있었지요. 해외에서 반드시 새로운 시각을 접할 수 있는 것은 아니었지만, 우리나라와는 다른 관점을 경험할 기회가 있었고, 이는 견문을 넓히는 데 큰 도움이 되었습니다. 이러한 제한된 기회를 가진 사람들만이 국경을 넘어 논의되는 주제를 접할 수 있었고, 자연스럽게 그들의 발언에 귀를 기울일 수밖에 없었습니다.

그러나 해외여행이 자유화되고 인터넷의 바다가 펼쳐지면서 상황이 급변했습니다. 과거에는 교수들만 접근할 수 있었던 정보도 이제는 대학원생, 나아가 일반인도 인터넷을 통해 손쉽게 접할 수 있게 되었습니다. 특권이 사라진 것입니다. 이제 누구나 인터넷에 접속하면 바다 건너 이야기를 들을 수 있게 되었고, 비록 대부분이 읽기만 하는 'ROM(Read-Only Member)' 역할에 그쳤지만, 지식의 공유는 더 이상 한정된 특권이 아니게 되었습니다. 하지만 여전히 정보의 대부분은 텍스트로 제공되었고, 깊이 있는 내용을 체감하기엔 한계가 있었습니다.

그런 와중에 유튜브가 우리의 세상에 들어왔습니다. 처음에는 일부 개인이나 단체 계정에서 컨퍼런스 영상을 업로드하는 수준이었지만, 점차 다양한 학술·기술 세션이 영상으로 제공되기 시작했습니다. 부족한 외국어 실력으로 띄엄띄엄 보더라도, 동영상을 통해 새로운 지식과 문물을 접하는 경험은 신선했습니다. 영상은 텍스트가 제공하지 못하는 현장감을 전달했고, 더 나아가 학습 효과를 높이는 데 큰 도움이 되었습니다. 하지만 여전히 언어의 장벽이 존재했습니다. 원문 자막이나 자동 번역 자막이 있긴 했지만, 완벽하지 않은 번역과 이해의 어려움이 남아 있었습니다.

동영상 학습이 효과적이라는 점에는 이견이 없지만, 과연 효율적인지는 의문이었습니다. 원하는 내용을 빠르게 찾기 어려웠기 때문입니다. 특정 정보가 어느 부분에 있는지 알기 위해서는 영상 전체를 살펴보거나, 자막 검색 기능을 활용해야 했습니다. 물론 유튜브의 자막 관련 플러그인을 사용하면 미리 내용을 살펴보고 특정 시간대로 이동할 수 있었지만, 집중력이 떨어지는 현대인들에게는 여전히 긴 동영상을 끝까지 시청하는 것이 쉽지 않았습니다.

그런데 AI가 이 모든 장벽을 허물었습니다.

이 글에서 소개하는 AI 도구는 다들 아시는 릴리스입니다. 도메인은 https://lilys.ai/입니다. 이 도구는 여러 기능이 있지만 유튜브 동영상 URL을 입력하면 자동으로 내용을 요약해 줍니다.

백문이 불여일견이라 했습니다. 제가 사용하는 사례를 공유해 보겠습니다.

제가 좋아하는 컨퍼런스 중에 NDC가 있습니다. 넥슨에서 주최하는 NDC말고요. 주로 오슬로나 멜버른에서 열립니다. https://ndcconferences.com/인데, 컨퍼런스가 끝나면 얼마지나지 않아 세션을 유튜브에 공개합니다. 유튜브 채널은 https://www.youtube.com/@NDC 입니다.

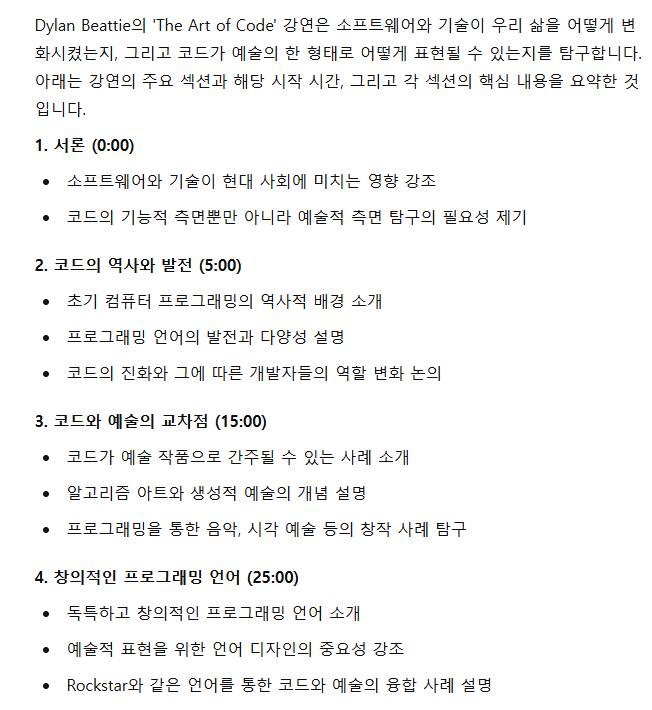

정말 여러 세션들이 있는데, 그중 한 세션의 URL을 릴리스에 넣어보겠습니다. 최신 세션도 있지만 인기있는 세션 하나를 선택해 봅니다. Dylan Beattie님이 발표한 The Art of Code세션이 있네요.

조금 시간이 흐르면 다음과 같이 시간대별 정보와 함께 깔끔하게 요약된 정보를 얻을 수 있습니다.

이제 실제 연사의 발표 내용에 집중할 수 있네요. 실제로 듣고 싶은 부분, 특히 발표 슬라이드와 함께 보고 싶은 부분이 있다면 시간을 클릭해서 해당 부분을 요약본 및 자막과 함께 볼 수 있습니다. AI는 우리의 학습 방식을 혁신적으로 변화시키고 있습니다. 아 좋은 세상!!

그 전에는 유튜브의 자막을 가져와서 그것을 GPT에 요약해 달라고 요청하고, 프롬프트도 조금 손을 봤어야 하는데 릴리즈를 이용하면 한방에 됩니다. 이제 발표자가 전달하고 싶은 이야기에 집중하면 되네요.

정말 편하지 않나요?

사실 편한 것을 넘어 큰 변화의 가능성을 내포하고 있다고 생각합니다. 대학 교육의 의미중 하나는 고등 교육을 받은 전문가와 이야기를 나누면서 문제 영역을 배운다는 것인데, 이제 배움을 주시는 분들이 해당 대학의 교수에 한정되지 않고 전세계 전문가들의 이야기를 들으면서, 조금 더 적극적으로 움직인다면 그 분들과 소통할 수 있는 세계가 열려있기 때문이죠. 교육 정책이나 거대 담론은 제 전문분야가 아니니 여기까지만!

사용해보면 역시 아직까진 한글은 서툽니다. 왠지 어색합니다. 영어에 대한 학습이 잘되어 있기 때문인지 STT는 영어가 좋습니다. 그래서 영문 컨퍼런스의 발표 동영상을 입력해 보면 왠지 모르게 릴리즈가 더 잘 요약하는 느낌입니다.

새벽에 일어나서 그냥 후다닥 적었네요. 저는 꽤 많은 도움을 받고 있습니다. 릴리즈의 더 나은 발전을 기대합니다!

관련글:

'2. 개발 > 2.0 개발 잡설' 카테고리의 다른 글

| AI에게 코딩을 시키더라도 개발자는 설계를 해야 한다. (0) | 2025.05.03 |

|---|---|

| 오라일리 레이더 문서 번역 정리 (0) | 2025.04.08 |

| 자동화의 가치 (0) | 2024.10.15 |

| 끝없는 학습과 실험, 그리고 고민: 개발자의 여정 (0) | 2024.06.13 |

| 21세기의 윈도우 개발환경 구축이란 (0) | 2024.06.08 |